這幾天在本地電腦用ollama部屬Deepseek R1(雖然只跑得動7b左右),本來想搭配在ComfyUI中使用,用的是comfyui_LLM_party 這個custom_node,確實能使用deepseek r1,但由於r1的輸出會包含<think></think>的思考過程,所以沒法直接使用,comfyui的文字分析處理節點不好用還得套一堆節點來處理。就乾脆寫一個小節點來專門處理。這個節點的運作很簡單,就是將API回應的資料傳給這個節點處理,就會解析成<think></think>的部分、思考後的結果的部分。

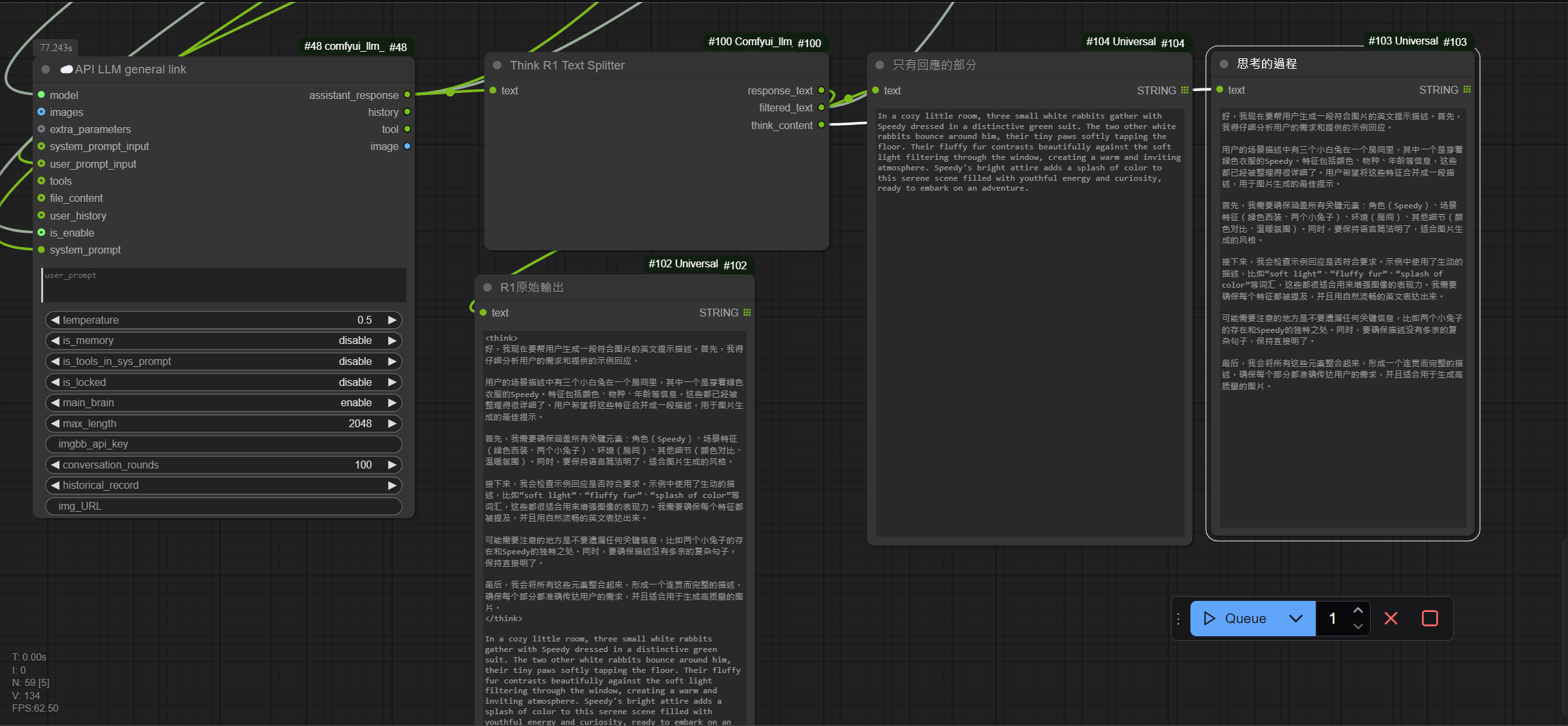

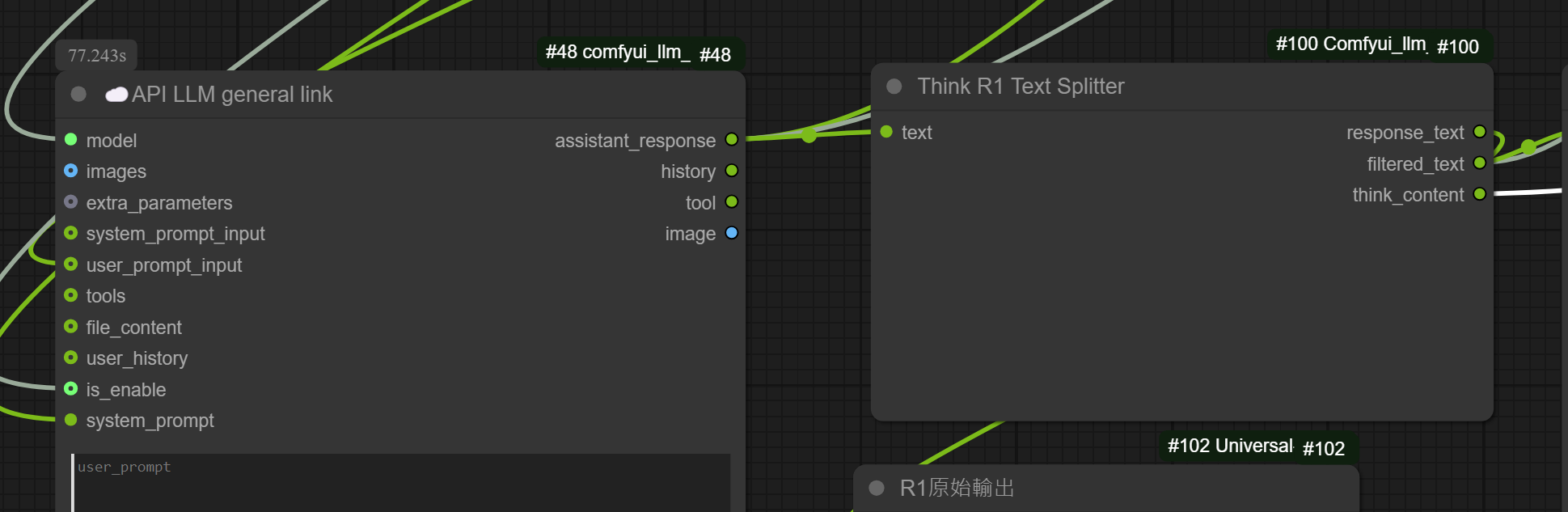

像這樣,一樣使用comfyui_LLM_party來呼叫ollama,並使用deepseek R1模型

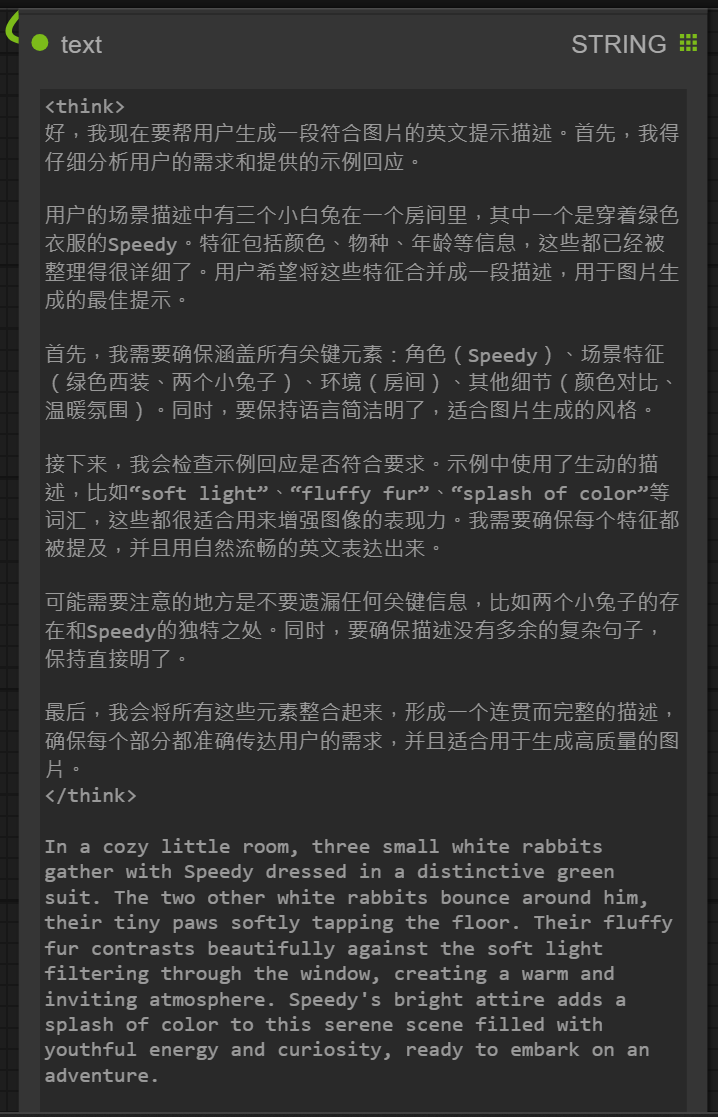

一般的回應長這樣,同時有<think>思考的內容,跟思考後得出的結論回應。

使用Think R1 Text Splitter節點,將原本的API LLM general link的assistant_response連結到Think R1 Text Splitter的Text

就能獲得這樣的輸出

response_text:等於原文(包含思考內容、跟回應)

filered_text:只有思考後的回應的內容 ( 一般用這個)

think_content:思考過程

這個custom_nodes,安裝後在comfyUI搜尋Think R1 Text Splitter節點

也可以看這篇ComfyUI測試DeepSeek R1 LLM(使用together.xyz)

前幾天測試時就發現它的思考過程挺不錯的,雖然回應的部分就一般(可能我運行的參數量太低),但我有個想法就是,可以採用它的思考過程+原始輸出的內容,再一次提交到gpt-4o或gpt-4o-mini,增強gpt-4o的回應品質,說不定也能達到o1、o1-mini的效果,成本還能省很多。

今天早上就看到有人有跟我同樣的想法,好像真的有用。

文章轉載或引用,請先告知並保留原文出處與連結!!(單純分享或非營利的只需保留原文出處,不用告知)

原文連結:

https://blog.aidec.tw/post/comfyui-deepseek-r1-text-splitter

若有業務合作需求,可寫信至: opweb666@gmail.com

創業、網站經營相關內容未來將發布在 小易創業筆記