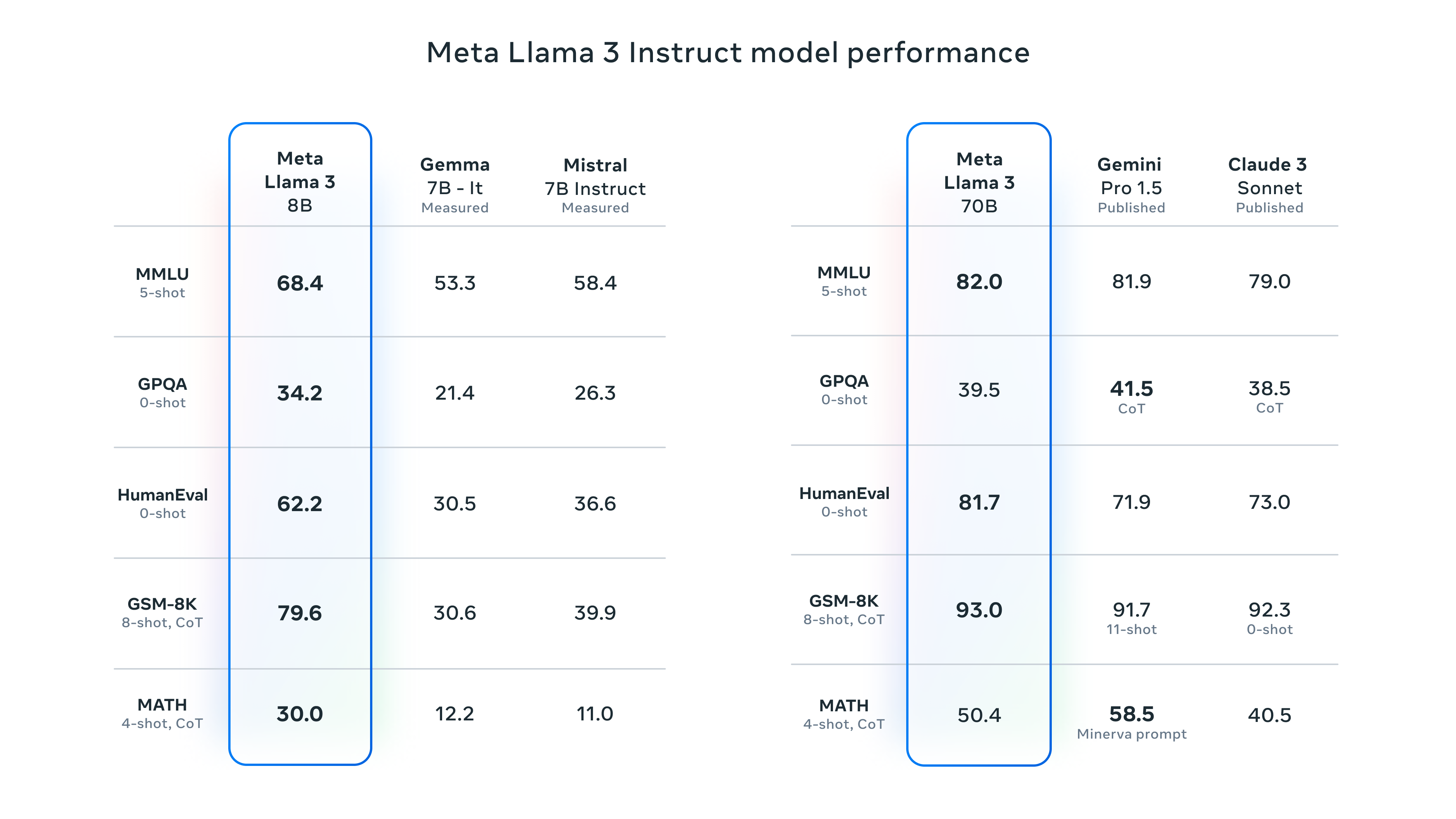

最近一直看到許多文章在說 LLAMA-3 有多厲害,能打敗GPT4什麼的~ 聽到這樣Aidec當然要來試試看

官方連結

Aidec使用ollama在本地運行Llama3 8B,跟使用雲服務跑Llama3 70b,實測下來Llama3確實有個強大的優點,那就是"快"

無論是8B還是70b,它的推理速度明顯比同級參數的模型快上不少。

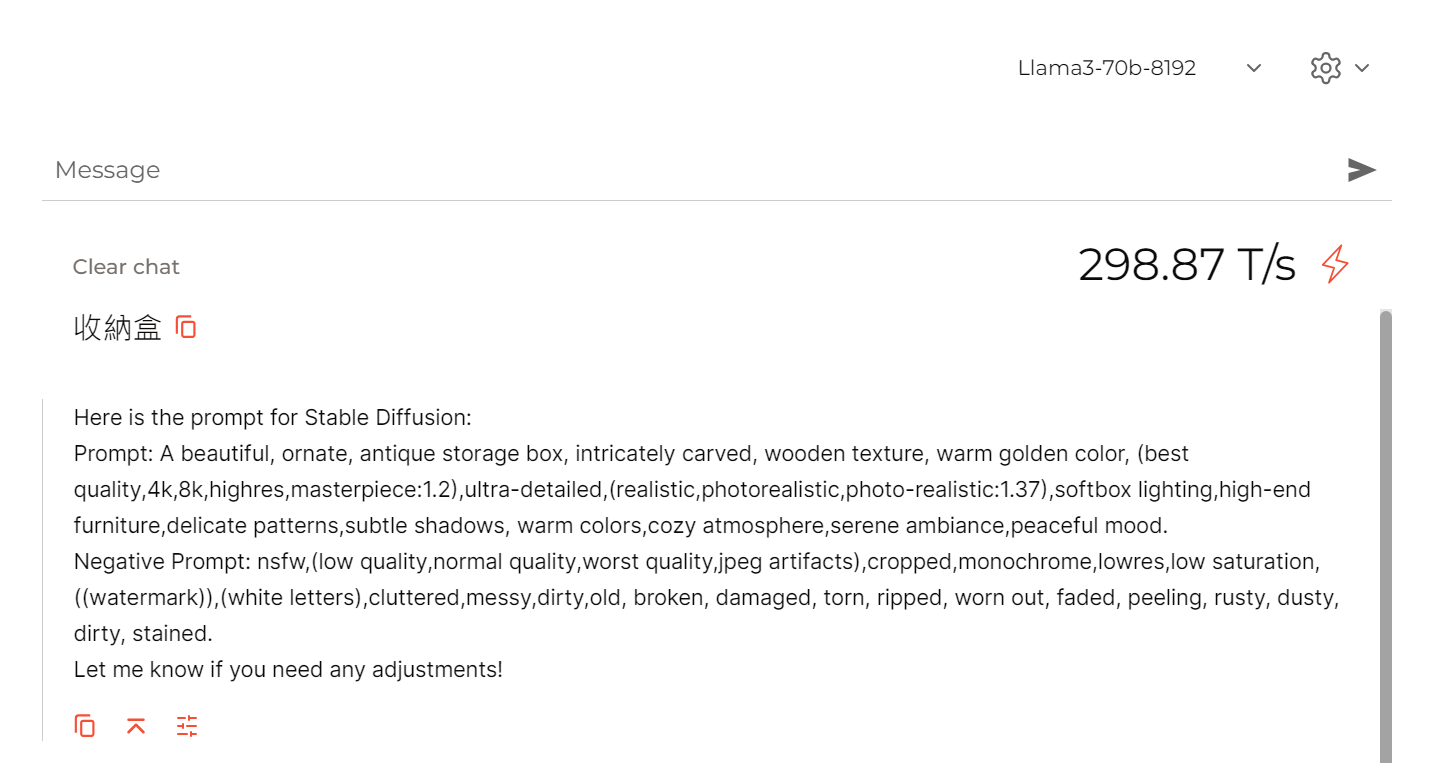

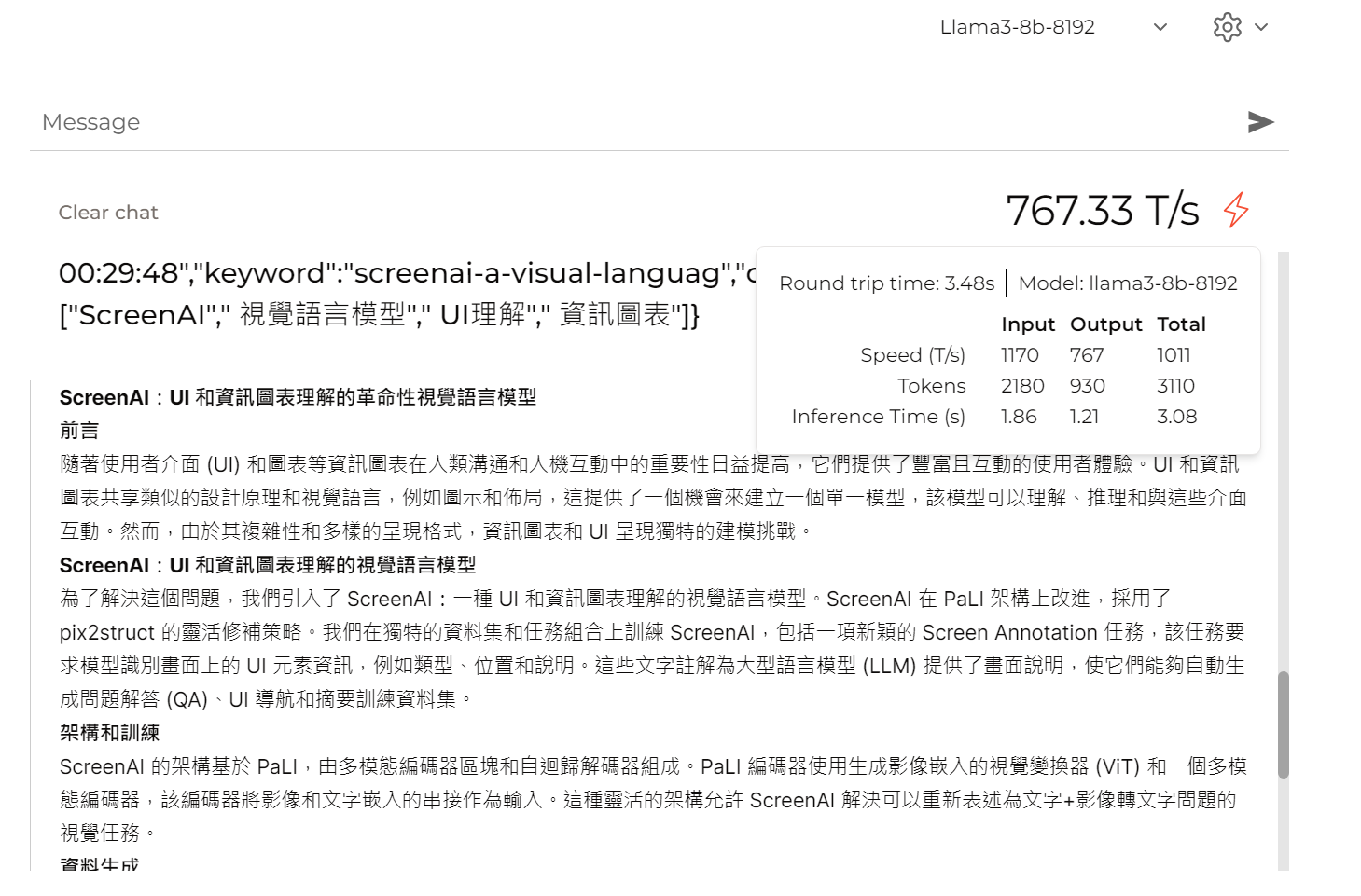

像是使用Groq線上測試Llama3 70b,每秒可以產生298.87 Tokens,我看X有貼文說最高可以到達每秒 800 Tokens

這個速度,確實比其他模型快了好多倍,推理能力的話,倒是覺得跟同級模型相比,沒有太大的差異。不過在同級推理差不多的情況下,速度快好幾倍的話,這的確是個很大的優勢(不過我發現它雖然回應的Tokens快,但初始響應速度不一定比其他模型快),低延遲響應個人覺得這也是個很重要的指標。

Llama3還有其他的缺點:

缺點一.

在中文的輸入與輸出會有一些小問題,例如要它整理資料,輸入的是中文,但回應會是英文。當然可以用System prompt來限制它,

zh-tw | 以繁體中文回應

這個指令幾乎在熱門的模型這招都有用,像是gpt 3.5、gemini ...,但上面這個在Llama3 無法完全作用,只要輸入的內容多一些,它前面會以中文回應,但中間就會突然變成用英文輸出。

解決方法:

在反覆嘗試後,發現了一個解決方法,不保證100% OK,但確實比上面的指令好,在System prompt加上

始終以繁體中文回應,無論字數有多少

這樣它就能都保持回應中文了,不會到一半變成英文

缺點二.

只能回應8192 Tokens,好吧!可能是看過gemini可以回應數萬Tokens,對它有點苛刻了,以一個開源模型來說能輸出這樣應該要好好地感謝一下。

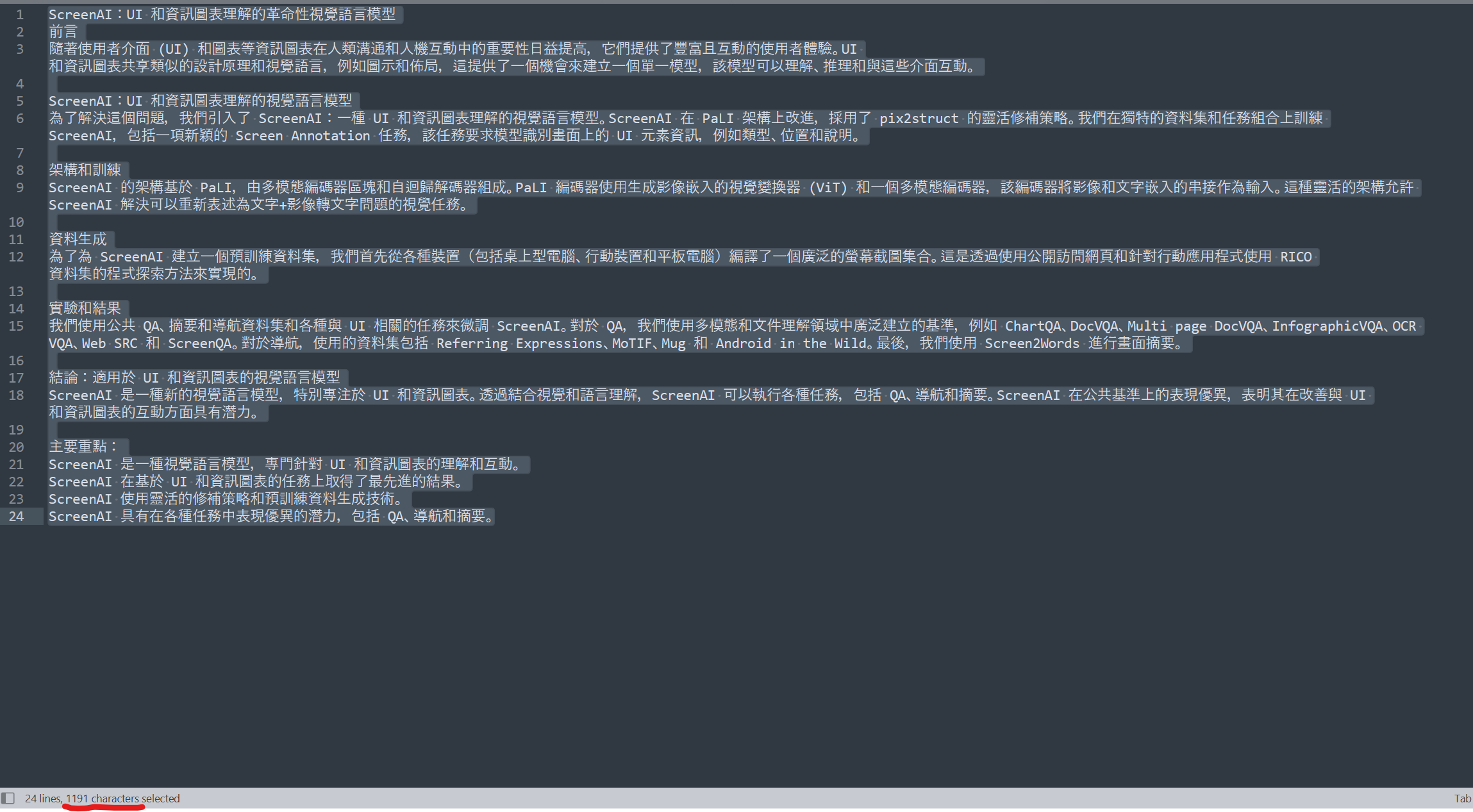

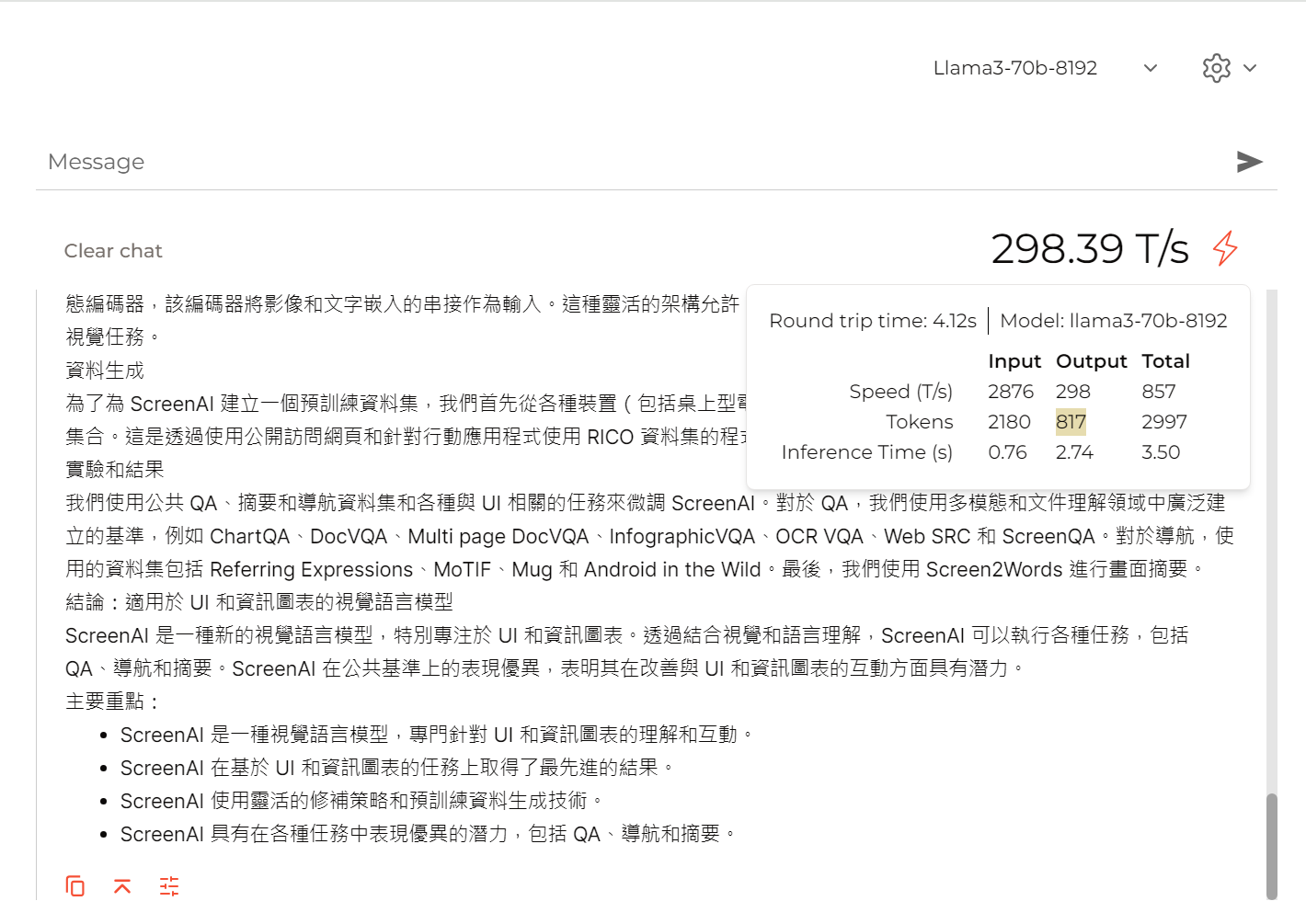

本來是要是說8192 Tokens,用中文字的話,只能輸出4096個字(像是gpt3、gpt4 幾乎一個中文字都算1.5~2個Tokens),但我發現groq的Llama3計算出來的Token明顯好很多,實際回應1191個字(有中英文),但output tokens只算817 tokens,明顯也比其他的模型少算很多Tokens,這在使用付費API時,支出就能少1.5~2倍!

好吧~ 本來是要說缺點的,說著說著好像變成優點了...

70B的回應速度,以及輸出的Tokens

缺點三

上面提到的兩個缺點,都.....變成不是缺點,但還是要硬提出它的缺點三,就是System prompt它不會完全的接受,一樣的System prompt在其他語言模型,20次可能會有1~2次沒按照System prompt的格式回應,但Llama3的發生率更高了,而且它也不是說完全就不聽System prompt,而是只聽部分的,像是我要它整理輸入的內容,回應標題,內文要有分段標題(且要用###格式)之類的....,它可能就會變成有時少了標題,有時少了分段標題,有時兩個都少

這使用人工處理回應內容時,倒不覺得如何,但假如是使用程式在做解析回應的內容時,這就變得很不可靠,會發生解析不出來的問題

缺點四

還是會一本正經地胡說八道,這不是Llama3獨有的缺點,而是所有的語言模型都有這個問題。像這個我讓它寫一篇關於收納的文章,回應的字數不對,內容也是亂說一通

註.目前的語言模型輸出的內容最好都親自驗證一番(但這又很花時間)

補充:

再次測試,假如是使用8B,每秒確實能跑到接近800Tokens,真的很驚人。70B就只能跑大概每秒近300Tokens

但我測試groq的gemini 7b 也能跑到803 T/s .... 所以這到底是groq的硬體設備好,還是模型的關係呢?

文章轉載或引用,請先告知並保留原文出處與連結!!(單純分享或非營利的只需保留原文出處,不用告知)

原文連結:

https://blog.aidec.tw/post/Meta-LLAMA-3

若有業務合作需求,可寫信至: opweb666@gmail.com

創業、網站經營相關內容未來將發布在 小易創業筆記